FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS =

TRANSFORMAÇÕES ⇔ INTERAÇÕES ⇔ TUNELAMENTO ⇔ EMARANHAMENTO ⇔ CONDUTIVIDADE ⇔ DIFRAÇÕES ⇔ estrutura eletrônica, spin, radioatividade, ABSORÇÕES E EMISSÕES INTERNA ⇔ Δ de temperatura e dinâmicas, transições de estados quântico Δ ENERGIAS, ⇔ Δ MASSA , ⇔ Δ CAMADAS ORBITAIS , ⇔ Δ FENÔMENOS , ⇔ Δ DINÂMICAS, ⇔ Δ VALÊNCIAS, ⇔ Δ BANDAS, Δ entropia e de entalpia, E OUTROS.

x

[EQUAÇÃO DE DIRAC].

+ FUNÇÃO TÉRMICA.

+ FUNÇÃO TÉRMICA.

+ FUNÇÃO DE RADIOATIVIDADE

, + FUNÇÃO DE TUNELAMENTO QUÂNTICO.

+ ENTROPIA REVERSÍVEL

+ FUNÇÃO DE CONDUÇÃO ELETROMAGNÉTICA

ENERGIA DE PLANCK

X

V [R] [MA] = Δe,M, Δf, ΔE, Δt, Δi, ΔT, ΔC, ΔE,ΔA, ΔD, ΔM......ΤDCG XΔe, ΔM, Δf, ΔE, Δt, Δi, ΔT, ΔC, ΔE,ΔA, ΔD, ΔM...... =

xsistema de dez dimensões de Graceli +DIMENSÕES EXTRAS DO SISTEMA DECADIMENSIONAL E CATEGORIAL GRACELI.[como, spins, posicionamento, afastamento, ESTRUTURA ELETRÔNICA, e outras já relacionadas]..- DIMENSÕES DE FASES DE ESTADOS DE TRANSIÇÕES DE GRACELI.xsistema de transições de estados, e estados de Graceli, fluxos aleatórios quântico, potencial entrópico e de entalpia. [estados de transições de fases de estados de estruturas, quântico, fenomênico, de energias, e dimensional [sistema de estados de Graceli].x

número atômico, estrutura eletrônica, níveis de energia

- TEMPO ESPECÍFICO E FENOMÊNICO DE GRACELI

- x

- X

- DT l T l E l Fl dfG lN l El tf lP l Ml tfefelTa l RlLl

Sistema de partículas em interação

Na teoria da probabilidade, um sistema de partículas em interação (IPS) é um processo estocástico em algum espaço de configuração dado por um espaço de sítio, um grafo infinito contável e um espaço de estado local, um espaço métrico compacto .[1] Mais precisamente, IPSs são processos de Marvok de tempo contínuo que descrevem o comportamento coletivo de componentes estocasticamente em interação. IPSs são os análogo de tempo contínuo dos autômatos celulares estocásticos. Entre os principais exemplos são o modelo de eleições, o processo de contato, o processo de exclusão simples assimétrico (PESA), a dinâmica de Glauber e, em particular, o modelo Ising estocástico.[2]

IPS são geralmente definidos através de seus geradores de Markov dando origem a um processo de Markov único utilizando semigrupos de Markov e o teorema de Hille-Yosida. Novamente o gerador é dada através das denominadas taxas de transição onde é um conjunto finito de sítios e com para todo . As taxas descrevem tempos de espera exponenciais do processo para saltar da configuração para a configuração . Geralmente, as taxas de transição são dadas na forma de uma medida finita em .

O gerador de um IPS tem a seguinte forma: primeiro, o domínio de é um subconjunto do espaço de "observáveis", isto é, o conjunto de valores reais de funções contínuas no espaço de configuração . Em seguida, para qualquer observável no domínio de , tem-se

.

X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

onde é a configuração igual a exceto que ela é invertida no sítio . é um novo parâmetro modelando a temperatura inversa.

Em processamento de sinal, o ruído branco é um sinal aleatório com igual intensidade em diferentes frequências, o que lhe dá uma densidade espectral de potência constante.[1] Com este significado e outros semelhantes, o termo é usado em muitas disciplinas científicas e técnicas, incluindo física, engenharia acústica, telecomunicações, previsão estatística e muitas outras. O ruído branco se refere a um modelo estatístico para sinais e fontes de sinal, em vez de qualquer sinal específico.

Em tempo discreto, o ruído branco é um sinal discreto cujas amostras são vistas como uma seqüência de variáveis aleatórias não autocorrelacionadas com média zero e variância finita. Uma única ocorrência de ruído branco é um choque aleatório. Dependendo do contexto, pode-se também exigir que as amostras sejam independentes e tenham distribuição de probabilidade idêntica (em outras palavras, variáveis aleatórias independentes e identicamente distribuídas são a representação mais simples de ruído branco).[2] Em particular, se cada amostra tem uma distribuição normal com média zero, o sinal é chamado de ruído branco gaussiano.[3]

As amostras de um sinal de ruído branco podem ser sequenciais no tempo ou dispostas ao longo de uma ou mais dimensões espaciais. No processamento digital de imagem, os pixels de uma imagem de ruído branco são dispostos tipicamente em uma grade retangular e assumidos como variáveis aleatórias independentes com distribuição de probabilidade uniforme ao longo de algum intervalo. O conceito pode ser definido também para sinais espalhados por domínios mais complexos, como uma esfera ou um toro.

Um sinal de ruído branco de largura de banda infinita é uma construção puramente teórica. A largura de banda do ruído branco é limitada na prática pelo mecanismo de geração de ruído, pelo meio de transmissão e pelas capacidades finitas de observação. Assim, um sinal aleatório é considerado "ruído branco" se for observado que tem um espectro plano ao longo da gama de frequências relevante ao contexto. Para um sinal de áudio, por exemplo, a faixa relevante é a faixa de frequências de som audíveis, entre 20 e 20.000 Hz. Esse sinal é ouvido como um som sibilante, semelhante ao som /ch/ em "chave". Em música e acústica, o termo "ruído branco" pode ser usado para qualquer sinal que tenha um som semelhantemente sibilante.

O termo "ruído branco" deriva da luz branca,[4] ainda que a luz que aparece branca não tenha geralmente uma densidade espectral de potência plana ao longo da faixa visível.

O termo ruído branco é às vezes usado no contexto dos métodos filogenéticos comparativos em estatística para se referir à falta de padrão filogenético em dados comparativos.[5] Por vezes, é usado em contextos não técnicos, no sentido metafórico de "conversa aleatória sem conteúdos significativos".[6][7]

Propriedades estatísticas[editar | editar código-fonte]

Estar não correlacionado no tempo não restringe os valores que um sinal pode ter. Qualquer distribuição de valores é possível (no entanto, deve haver polarização de corrente contínua zero). Mesmo um sinal binário que só pode assumir os valores 1 ou -1 será branco se a seqüência for estatisticamente não correlacionada. O ruído que tem uma distribuição contínua, tal como uma distribuição normal, pode naturalmente ser branco.

É freqüentemente assumido de forma incorreta que o ruído gaussiano (isto é, o ruído com distribuição de amplitude gaussiana, ou seja, distribuição normal) se refere necessariamente ao ruído branco, ainda que nenhuma das duas propriedades implique a outra. O caráter gaussiano diz respeito à distribuição de probabilidade no que tange ao valor, neste contexto, a probabilidade de que o sinal caia em qualquer faixa particular de amplitudes, enquanto o termo "branco" refere-se à forma como a potência do sinal é distribuído (ou seja, independentemente) ao longo do tempo ou entre freqüências.

Podemos, portanto, encontrar ruídos brancos de Gauss, mas também ruídos brancos de Poisson e de Cauchy, por exemplo. Assim, as duas palavras ("gaussiano" e "branco") são ambas muitas vezes especificadas em modelos matemáticos de sistemas. O ruído branco gaussiano é uma boa aproximação de muitas situações do mundo real e gera modelos matematicamente tratáveis. Estes modelos são usados com tanta frequência que o termo ruído gaussiano branco aditivo tem uma abreviação padrão: AWGN (Additive White Gaussian Noise, em inglês).

O ruído branco é a derivada quadrática média generalizada do processo de Wiener ou movimento browniano.

Uma generalização para elementos aleatórios em espaços dimensionais infinitos, como campos aleatórios, é a medida de ruído branco ou espaço nuclear.

Aplicações práticas[editar | editar código-fonte]

Música[editar | editar código-fonte]

O ruído branco é comumente usado na produção de música eletrônica, geralmente de forma direta ou como entrada para um filtro a fim de criar outros tipos de sinal de ruído. É usado extensivamente na síntese de áudio, normalmente para recriar instrumentos de percussão, tais como pratos ou caixas, que têm alto conteúdo de ruído em seu domínio de freqüência.

Engenharia eletrônica[editar | editar código-fonte]

O ruído branco é também usado para obter a resposta ao impulso de um circuito elétrico, em particular de amplificadores e outros equipamentos de áudio. Ele não é usado para testar alto-falantes já que seu espectro contém uma quantidade muito grande de conteúdo de alta freqüência. O ruído rosa, que difere do ruído branco por ter energia igual em cada oitava, é usado para testar transdutores como alto-falantes e microfones.

Acústica[editar | editar código-fonte]

Para configurar a equalização para um concerto ou outra performance em um local, uma pequena explosão de ruído branco ou rosa é enviada pelo sistema de PA (Public Address, em inglês) e monitorada a partir de vários pontos no local para que o engenheiro possa dizer se a acústica do local naturalmente aumenta ou corta qualquer freqüência. O engenheiro pode então ajustar a equalização geral para assegurar uma mistura equilibrada.

Computação[editar | editar código-fonte]

O ruído branco é usado como base de alguns geradores de números aleatórios. Por exemplo, o Random.org usa um sistema de antenas atmosféricas para gerar padrões de dígitos aleatórios a partir de ruído branco.

Tratamento de zumbido[editar | editar código-fonte]

O ruído branco é uma fonte comum de ruído sintético usada para mascaramento sonoro por um mascarador de zumbido.[8] As máquinas de ruído branco e outras fontes de ruído branco são vendidas como intensificadores de privacidade, auxiliares de sono e mascaradores de zumbido.[9] Uma alternativa é o uso de um rádio FM sintonizado em frequências não usadas ("estáticas"), fonte mais simples e acessível de ruído branco.[10] No entanto, o ruído branco gerado por um receptor comum de rádio comercial sintonizado em uma frequência não usada é extremamente vulnerável à contaminação por sinais espúrios, tais como estações de rádio adjacentes, harmônicas de estações de rádio não adjacentes, equipamento elétrico nas proximidades da antena de recepção causando Interferências ou mesmo eventos atmosféricos, tais como luz solar e especialmente raios.

Ambiente de trabalho[editar | editar código-fonte]

Os efeitos do ruído branco sobre a função cognitiva são ambíguos. Recentemente, um pequeno estudo descobriu que a estimulação de fundo por ruído branco melhora o funcionamento cognitivo em estudantes de segundo grau com transtorno de déficit de atenção com hiperatividade (TDAH), ao mesmo tempo que diminui o desempenho de estudantes que não têm TDAH.[11][12] Outro trabalho indica que é eficaz na melhoria do humor e desempenho dos trabalhadores por mascarar o ruído do escritório em segundo plano,[13] mas diminui o desempenho cognitivo em tarefas complexas de classificação de cartões.[14]

Definições matemáticas[editar | editar código-fonte]

Vetor de ruído branco[editar | editar código-fonte]

Um vetor aleatório (isto é, um processo parcialmente indeterminado que produz vetores de números reais) é um vetor de ruído branco ou um vetor aleatório branco se seus componentes tiverem cada um uma distribuição de probabilidade com média zero e variância finita e forem estatisticamente não correlacionados, ou seja, sua distribuição de probabilidade conjunta deve ser o produto das distribuições dos componentes individuais.[15]

Uma condição necessária (mas, em geral, insuficiente) para a independência estatística de duas variáveis é que elas sejam estatisticamente não correlacionadas, isto é, sua covariância seja zero. Portanto, a matriz de covariância dos componentes de um vetor de ruído branco com elementos deve ser uma matriz diagonal por , em que cada elemento diagonal ii é a variância do componente ; e a matriz de correlação deve ser a matriz identidade por .

Em particular, se, além de independentes, toda variável em também tiver uma distribuição normal com média zero e mesma variância , é um vetor gaussiano de ruído branco. Neste caso, a distribuição conjunta de é uma distribuição normal multivariada. A independência entre as variáveis implica então que a distribuição tem simetria esférica no espaço -dimensional. Portanto, qualquer transformação ortogonal do vetor resultará em um vetor aleatório branco gaussiano. Em particular, sob a maioria dos tipos de transformada discreta de Fourier, tais como a transformada rápida de Fourier e a transformada discreta de Hartley, a transformada de também será um vetor de ruído branco gaussiano, isto é, os coeficientes de Fourier de serão variáveis gaussianas independentes com média zero e mesma variância .

O espectro de potência de um vetor aleatório pode ser definido como o valor esperado do módulo ao quadrado de cada coeficiente de sua transformada de Fourier , isto é, . Sob esta definição, um vetor de ruído branco gaussiano terá um espectro de potência perfeitamente plano, com para todo .

Se for um vetor aleatório branco, mas não gaussiano, seus coeficientes de Fourier não serão completamente independentes uns dos outros, ainda que, para grandes e distribuições de probabilidade comuns, as dependências sejam muito sutis e suas correlações entre pares possam ser assumidas como iguais a zero.

Muitas vezes, a condição mais fraca "estatisticamente não correlacionado" é usada na definição de ruído branco, em vez de "estatisticamente independente". No entanto, algumas das propriedades comumente esperadas do ruído branco (como o espectro de potência plano) podem não ser válidas para esta versão mais fraca. Sob este pressuposto, a versão mais estrita pode ser referida explicitamente como vetor independente de ruído branco.[16] Outros autores usam fortemente branco e fracamente branco.[17]

Um exemplo de um vetor aleatório que é de "ruído branco gaussiano" no sentido fraco, mas não no forte é , em que é uma variável aleatória normal com média zero e é igual a ou a , com igual probabilidade. Estas duas variáveis são não correlacionadas e normalmente distribuídas individualmente, mas não são normalmente distribuídas conjuntamente, nem independentes. Se for rotacionado em 45 graus, seus dois componentes ainda serão não correlacionados, mas suas distribuições não serão mais normais.

Em algumas situações, pode-se relaxar a definição, permitindo que cada componente de um vetor aleatório branco tenha um valor esperado diferente de zero. Especialmente no processamento de imagens, em que as amostras são tipicamente restritas a valores positivos, pode-se tomar como a metade do valor máximo da amostra. Neste caso, o coeficiente de Fourier correspondente ao componente de frequência zero também terá um valor esperado não nulo e o espectro de potência será plano apenas sobre as frequências não nulas.

Ruído branco de tempo contínuo[editar | editar código-fonte]

Para definir a noção de "ruído branco" na teoria dos sinais de tempo contínuo, deve-se substituir o conceito de "vetor aleatório" por um sinal aleatório de tempo contínuo, isto é, um processo aleatório que gera uma função de um parâmetro de valor real .

Tal processo é um ruído branco no sentido mais forte se o valor para qualquer tempo for uma variável aleatória estatisticamente independente de toda a sua história antes de . Uma definição mais fraca exige independência apenas entre os valores e a cada par de tempos distintos e . Uma definição ainda mais fraca requer apenas que estes pares e sejam não correlacionados.[18] Como no caso discreto, alguns autores adotam a definição mais fraca para "ruído branco" e usam o termo independente para se referir a uma das definições mais fortes. Outros usam fracamente branco e fortemente branco para fazer a distinção.

No entanto, uma definição precisa destes conceitos não é trivial, porque algumas quantidades que forem somas finitas no caso discreto finito devem ser substituídas por integrais que podem não convergir. De fato, o conjunto de todas as instâncias possíveis de um sinal não é mais um espaço de dimensão finita , mas um espaço funcional de dimensões infinitas. Além disso, por qualquer definição, um sinal de ruído branco teria que ser essencialmente descontínuo em cada ponto. Portanto, mesmo as operações mais simples envolvendo , como a integração em um intervalo finito, exigem mecanismos matemáticos avançados.

Alguns autores exigem que cada valor seja uma variável aleatória de valor real com valor esperado e alguma variação finita . Então, a covariância entre os valores em dois tempos e está bem definida: será zero se os tempos forem distintos e se forem iguais. Contudo, por esta definição, a integral

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

sobre qualquer intervalo com largura positiva seria simplesmente o produto da largura pela expectativa: . Esta propriedade tornaria o conceito inadequado como um modelo de sinais físicos de "ruído branco".

Portanto, a maioria dos autores define o sinal indiretamente, especificando valores não nulos para as integrais de e ao longo de qualquer intervalo , como uma função de sua largura . Nesta abordagem, entretanto, o valor de em um tempo isolado não pode ser definido como uma variável aleatória de valor real. Além disso, a covariância se torna infinita quando ; e a função autocorrelação deve ser definida como , em que é alguma constante real e é a função delta de Dirac.

Nesta abordagem, especifica-se normalmente que a integral de ao longo de um intervalo é uma variável aleatória real com distribuição normal, média zero e variância ; e também que a covariância das integrais , é , em que é a largura da interseção dos dois intervalos . Este modelo é chamado de sinal (ou processo) de ruído branco gaussiano.

Ruído gaussiano é um ruído estatístico cuja função densidade de probabilidade (FDP) é igual a da distribuição normal, que é também conhecida como distribuição gaussiana.[1][2]

A função densidade de probabilidade de uma variável aleatória gaussiana é dada por:

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

Em matemática, o teorema da continuidade de Kolmogorov é um teorema que garante que um processo estocástico que satisfaz certas condições quanto aos momentos de seus incrementos seja contínuo (ou, mais precisamente, tenha uma "versão contínua"), Recebe este nome em homenagem ao matemático soviético Andrei Kolmogorov.[1]

Demonstração[editar | editar código-fonte]

Considere um espaço métrico completo tal que é mensurável e considere um processo estocástico. Suponha que, para todos os tempos , há constantes positivas tal que

XFUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

para todo . Então, há uma modificação de que é um processo contínuo, isto é, um processo tal que

- é um processo contínuo amostral;

- Para todo momento , .

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

Em matemática, o teorema da extensão de Kolmogorov (também conhecido como teorema da existência de Kolmogorov ou teorema da consistência de Kolmogorov) é um teorema que garante que uma coleção adequadamente "consistente" de distribuições de dimensões finitas definirá um processo estocástico. Recebe este nome em homenagem ao matemático russo Andrei Kolmogorov.[1]

Afirmação[editar | editar código-fonte]

Considere que denota algum intervalo (pensado como "tempo") e que . Para cada e uma sequência finita de tempos distintos , considere a medida de probabilidade em . Suponha que estas medidas satisfaçam duas condições de consistência:

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

2. Para todos os conjuntos mensuráveis ,

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

para todo , todo e para os conjuntos mensuráveis , isto é, tem como suas distribuições de dimensões finitas relativas aos tempos .[1]

Na verdade, é sempre possível tomar como espaço de probabilidade subjacente e assumir para o processo canônico . Por isso, uma forma alternativa de afirmar o teorema da extensão de Kolmogorov é dizer que, garantida a aplicação das condições de consistência descritas acima, há uma (única) medida em com marginais para qualquer coleção finita de tempos . O teorema da extensão de Kolmogorov se aplica quando é incontável, mas o preço a se pagar para este nível de generalidade é que a medida é definida apenas na sigma-álgebra produto de , o que não é muito valioso.

Teorema de Donsker

Em teoria da probabilidade, o teorema de Donsker (também conhecido como princípio da invariância de Donsker, ou teorema central do limite funcional), em homenagem ao matemático Monroe D. Donsker, é uma extensão funcional do teorema central do limite.[1]

Definição formal[editar | editar código-fonte]

Seja uma sequência de variáveis aleatórias independentes e identicamente distribuídas (i.i.d.) com média 0 e variância 1. Seja .

X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

O processo estocástico é conhecido como um passeio aleatório. Definindo o passeio aleatório escalado por

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

O teorema central do limite afirma que converge em distribuição para uma variável aleatória gaussiana padrão conforme . O princípio da invariância de Donsker[1][2] extende essa convergência para toda a função . Mais precisamente, em sua forma moderna, o princípio da invariância de Donsker afirma que: com variáveis aleatórias tomando valores no espaço de Skorokhod , a função aleatória converge em distribuição para um movimento browniano padrão conforme

Seja a função distribuição empírica da sequência das variáveis aleatórias i.i.d. com função de distribuição . Definindo a versão centrada e reduzida de por

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

indexadas por . Pelo teorema central do limite clássico, para fixo, a variável aleatória converge em distribuição para uma variável aleatória gaussiana normal , com média zero e variância de conforme o tamanho da amostra cresce.

Teorema (Donsker, Skorokhod, Kolmogorov) — A sequência de Gn(x), como elementos aleatórios do espaço de Skorokhod , converge em distribuição para um processo gaussiano G com média zero e covariância dada por

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

O processo pode ser escrito como , onde é uma ponte browniana padrão no intervalo unitário.

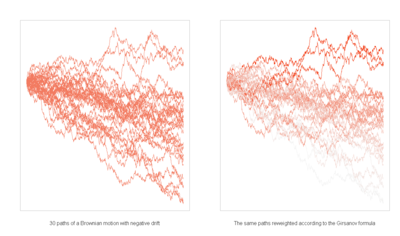

Teorema de Girsanov

Na teoria da probabilidade, o teorema de Girsanov (em nome de Igor Vladimirovich Girsanov) descreve como a dinâmica de processos estocásticos muda quando o a medida original é alterada para uma medida da probabilidade equivalente.[1]:607 O teorema é especialmente importante na teoria da matemática financeira, na medida em que converte a probabilidade de uma medida física que descreve a probabilidade de que um ativo subjacente (como um preço ou uma taxa de juros) ter um determinado valor ou valores em uma medida de risco-neutro, uma uma ferramenta muito útil para o cálculo de preços derivados do subjacente.

História[editar | editar código-fonte]

Resultados deste tipo foram pela primeira vez demonstrados por Cameron–Martin na década de 1940 e por Girsanov, em 1960.[2] Eles foram, posteriormente, estendido para classes mais gerais de processo que culminaram na forma geral de Lenglart (1977).

Significado[editar | editar código-fonte]

O teorema de Girsanov é importante na teoria geral de processos estocásticos, pois permite que o resultado-chave de que se Q é uma medida absolutamente contínua com respeito a P , então, todo P-semimartingale é um Q-semimartingale.[3]

Demonstração do teorema[editar | editar código-fonte]

Apresentamos o teorema primeiro para o caso especial quando o processo estocástico subjacente é um processo de Wiener. Este caso especial é suficiente para preços de risco-neutro no modelo de Black-Scholes e em muitos outros modelos (por exemplo, modelos contínuos).

Deixe ser um processo de Wiener espaço de probabilidade Wiener . Deixe ser um processo adaptado mensurável para a filtragem natural do processo de Wiener com .

Defina o exponencial Doléans de X com respeito a W

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

Se é um martingale estritamente positivo, uma medida de probabilidade Q pode ser definida em de tal forma a termos um derivativo de de Radon–Nikodym

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

Em seguida, para cada t a medida Q restrita para os campos sigma não aumentados é equivalente a P restrito a . Além disso, se Y é um local de martingale em P, então o processo

é um Q local de martingale no espaço de probabilidade filtrado .

Variação quadrática

Esta página cita fontes confiáveis, mas que não cobrem todo o conteúdo. (Maio de 2017)

|

Em matemática, a variação quadrática é usada na análise de processos estocásticos, como o movimento browniano e outros martingales. A variação quadrática é só mais um tipo de variação de um processo.

Definição[editar | editar código-fonte]

Suponha que é um processo estocástico de valores reais definido em um espaço de probabilidade e com um índice de tempo que varia entre os números reais não-negativos. Sua variação quadrática é o processo, escrito como , definido como

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

em que varia entre as partições do intervalo e a norma da partição P é a malha. Este limite, se existe, é definido usando a convergência de variáveis aleatórias. Note que um processo pode ser de variação quadrática finita no sentido da definição dada aqui e seus caminhos podem ser, não obstante, quase certamente de variação quadrática infinita para todo no sentido clássico de tomar o supremo da soma de todas as partições; este é particularmente o caso do movimento browniano.

Mais geralmente, a covariância (ou variância cruzada) de dois processos e é

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

A covariância pode ser escrita em termos de variação quadrática pela identidade de polarização:

- [1]

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

Processos de variação finita[editar | editar código-fonte]

Diz-se que um processo tem variação finita se tiver variação limitada para cada intervalo de tempo finito (com probabilidade 1). Tais processos são muito comuns e incluem, particularmente, todas as funções continuamente diferenciáveis. A variação quadrática existe para todos os processos de variação contínua e finita e é zero.

Esta afirmação pode ser generalizada a processos não-contínuos. Qualquer processo de variação finita càdlàg tem variação quadrática igual à soma dos quadrados dos saltos de . Para afirmar isto mais precisamente, o limite à esquerda de referente a é denotado por e o salto de no tempo pode ser escrito como . Então, a variação quadrática é dada por

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

A prova de que processos de variação finita e contínua têm variação quadrática zero segue da seguinte desigualdade. Aqui, é uma partição do intervalo e é a variação de sobre .

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

Pela continuidade de , este desaparece no limite conforme vai a zero.

Processos de Itō[editar | editar código-fonte]

A variação quadrática de um movimento browniano padrão existe e é dada por . Isto se generaliza a processos de Itō que, por definição, podem ser expressos em termos de integrais de Itō

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

em que é um movimento browniano. Qualquer processo como tal tem variação quadrática dada por

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

Semimartingales[editar | editar código-fonte]

É possível mostrar que variações e covariâncias quadráticas de todos os semimartingales existem. Eles formam uma parte importante da teoria do cálculo estocástico, aparecendo no lema de Itō, que é a generalização da regra da cadeia da integral de Itō. A covariância quadrática também aparece na fórmula de integração por partes.

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

que pode ser usada para computar .

De outra forma, isto pode ser escrito como uma equação diferencial estocástica:

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

em que

Martingales[editar | editar código-fonte]

Todos os martingales càdlàg e martingales locais têm variação quadrática bem definida, que segue do fato de que tais processos são exemplos de semimartingales. Pode ser mostrado que a variação quadrática de um martingale localmente quadrado integrável é o único processo contínuo à direita e crescente a partir de zero, com saltos , tal que é um martingale local. Uma prova da existência de (sem uso de cálculo estocástico) é dada em Karandikar-Rao.[2]

Um resultado útil para martingales quadrado integráveis é a isometria de Itō, que pode ser usada para calcular a variância de integrais de Itō,

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

Este resultado se mantém sempre que for um martingale quadrado integrável càdlàg e for um processo previsível limitado, sendo frequentemente usado na construção da integral de Itō.

Outro importante resultado é a desigualdade de Burkholder-Davis-Gundy, que dá limites ao máximo de um martingale nos termos da variação quadrática. Para um martingale local começando em zero, com máximo denotado por e qualquer número real , a desigualdade é

- X

FUNÇÃO FUNDAMENTAL E GERAL DO SISTEMA [SDCTIE GRACELI] DE INTERAÇÕES, TRANSFORMAÇÕES EM CADEIAS, DECADIMENSIONAL E CATEGORIAL GRACELI.E DE ESTADOS TRANSICIONAIS

Aqui, são constantes que dependem da escolha de , mas não do martingale ou do tempo usado. Se for um martingale local contínuo, então a desigualdade de Burkholder-Davis-Gundy se mantém para qualquer .

Um processo alternativo, a variação quadrática previsível, é usado às vezes para martingales localmente quadrado integráveis. É escrita como e definida como sendo o único processo previsível contínuo à direita e crescente a partir de zero, tal que é um martingale local. Sua existência segue do teorema da decomposição de Doob-Meyer e, para martingales locais contínuos, é igual à variação quadrática.

[EQUAÇÃO DE DIRAC].

[EQUAÇÃO DE DIRAC].

+ FUNÇÃO DE RADIOATIVIDADE

+ FUNÇÃO DE RADIOATIVIDADE

+ FUNÇÃO DE TUNELAMENTO QUÂNTICO.

+ FUNÇÃO DE TUNELAMENTO QUÂNTICO. + ENTROPIA REVERSÍVEL

+ ENTROPIA REVERSÍVEL ![\sigma =q(n\mu _{n}+p\mu _{p})[\Omega .cm]^{{-1}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/53d1173dd9d9ec55715f1f4beb1ea5dcd4932bc8) FUNÇÃO DE CONDUÇÃO ELETROMAGNÉTICA

FUNÇÃO DE CONDUÇÃO ELETROMAGNÉTICA ENERGIA DE PLANCK

ENERGIA DE PLANCK

![{\displaystyle Lf(\eta )=\sum _{\Lambda }\int _{\xi :\xi _{\Lambda ^{c}}=\eta _{\Lambda ^{c}}}c_{\Lambda }(\eta ,d\xi )[f(\xi )-f(\eta )]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/134ca71b6edcadff978d0bf7479b43224652b187)

![{\displaystyle c_{i}(\eta ,\eta ^{i})=\exp[-\beta \sum _{j:|j-i|=1}\eta _{i}\eta _{j}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/35dad977a443870640d4225408602b182ee0fee4)

![{\displaystyle x=[x_{1},x_{2}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2645ee2f60d2c7b6e8de6a749a992d0bfb0152ea)

![{\displaystyle W_{[a,a+r]}=\int _{a}^{a+r}w(t)\,dt}](https://wikimedia.org/api/rest_v1/media/math/render/svg/86539c178bca46d69cba7d48f7be918f07e5f0f8)

![{\displaystyle [a,a+r]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/49d0334655650dac92061c74f417cd24118e5a1a)

![{\displaystyle I=[a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6d6214bb3ce7f00e496c0706edd1464ac60b73b5)

![{\displaystyle \mathbb {E} [d(X_{t},X_{s})^{\alpha }]\leq K|t-s|^{1+\beta }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aa74f781a13ca5fe1d1aeebbb8f7350fcff20bf1)

![{\displaystyle W^{(n)}(t):={\frac {S_{\lfloor nt\rfloor }}{\sqrt {n}}},\qquad t\in [0,1].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0c5b96070ae726d73a42ecf4e1da69b3ba4ce1ac)

![{\displaystyle W^{(n)}:=(W^{(n)}(t))_{t\in [0,1]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0c9bd97748f3aad3545d97aac1342b6bc4ed96fe)

![{\displaystyle {\mathcal {D}}[0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f52583cc1475b9a987e8ca67473773444b0be01c)

![{\displaystyle W:=(W(t))_{t\in [0,1]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1fc2ccf9ee0af262c9746f48cd2cdb5bf3995e17)

![{\displaystyle \operatorname {cov} [G(s),G(t)]=E[G(s)G(t)]=\min\{F(s),F(t)\}-F(s)F(t).\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b0ac996bd20a9112d2f7b86dab791c3f9fd4d102)

![{\displaystyle {\mathcal {E}}(X)_{t}=\exp \left(X_{t}-{\frac {1}{2}}[X]_{t}\right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fd6ff6bfdcdb6b831416cc1d3473cf847f8e09a5)

![{\displaystyle {\tilde {Y}}_{t}=Y_{t}-\left[Y,X\right]_{t}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d731988cd47214ec60768ae6d70a8d619e057a3d)

![{\displaystyle [X]_{t}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7e4b700663439c3b9e16662c2382dbb2af8a671b)

![{\displaystyle [X]_{t}=\lim _{\Vert P\Vert \rightarrow 0}\sum _{k=1}^{n}(X_{t_{k}}-X_{t_{k-1}})^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8647cd8fd0d88ad0347388c931368ce0d21dd22e)

![{\displaystyle [0,t]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/37d2d2fa44908c699e2b7b7b9e92befc8283f264)

![{\displaystyle [X,Y]_{t}=\lim _{\Vert P\Vert \to 0}\sum _{k=1}^{n}\left(X_{t_{k}}-X_{t_{k-1}}\right)\left(Y_{t_{k}}-Y_{t_{k-1}}\right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2b89252b8804e009ac85f5d8ba1cbe16f5f58be6)

![{\displaystyle [X,Y]_{t}={\tfrac {1}{4}}([X+Y]_{t}-[X-Y]_{t}).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/84ce0dec46a8032eb977b3abc9dbd00ae949caef)

![{\displaystyle [X]_{t}=\sum _{0<s\leq t}(\Delta X_{s})^{2}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8505320160e36656ac49b8f7091529e4bd1d7c6d)

![{\displaystyle [B]_{t}=t}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f26e6b82731e35a71a816fd66c5bb636c799ed4b)

![{\displaystyle [X]_{t}=\int _{0}^{t}\sigma _{s}^{2}\,ds.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6f1e8d1aa46d491764e6adae268e99b6046a453a)

![{\displaystyle X_{t}Y_{t}=X_{0}Y_{0}+\int _{0}^{t}X_{s-}\,dY_{s}+\int _{0}^{t}Y_{s-}\,dX_{s}+[X,Y]_{t},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d712fa00e01765333733cab74d58c081d7b739b8)

![{\displaystyle [X,Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/94470b44d283fde62130212956058ca6b727da37)

![{\displaystyle \,dX_{t}\,dY_{t}=\,d[X,Y]_{t}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6030acc6ab4db78d0cf77bb2572b36d2627fd06f)

![{\displaystyle [M]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e5ca74e595b2281c0aef1897ecafa282d1f182e2)

![{\displaystyle \Delta [M]=\Delta M^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/139f6dee2d74582b0c228dfaa1b22541ba4ce6c9)

![{\displaystyle M^{2}-[M]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aaf3f404fd6c1d2124c90e5e569df2cc124c1f77)

![{\displaystyle \mathbb {E} \left(\left(\int _{0}^{t}H\,dM\right)^{2}\right)=\mathbb {E} \left(\int _{0}^{t}H^{2}\,d[M]\right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5b8fef987dc6ec042ba49983cf7d48bd42db0d23)

![{\displaystyle c_{p}\mathbb {E} ([M]_{t}^{p/2})\leq \mathbb {E} ((M_{t}^{*})^{p})\leq C_{p}\mathbb {E} ([M]_{t}^{p/2}).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d544974b55ef823b44f3bb7585f6d485eac46866)